CC BY 4.0 (除特别声明或转载文章外)

BERT series

BERT 阶段训练是 Self-supervised Learning,但是在 Downstream 做 fine-tune 的时候是 Supervised Learning

How to use BERT

Case1

Case2

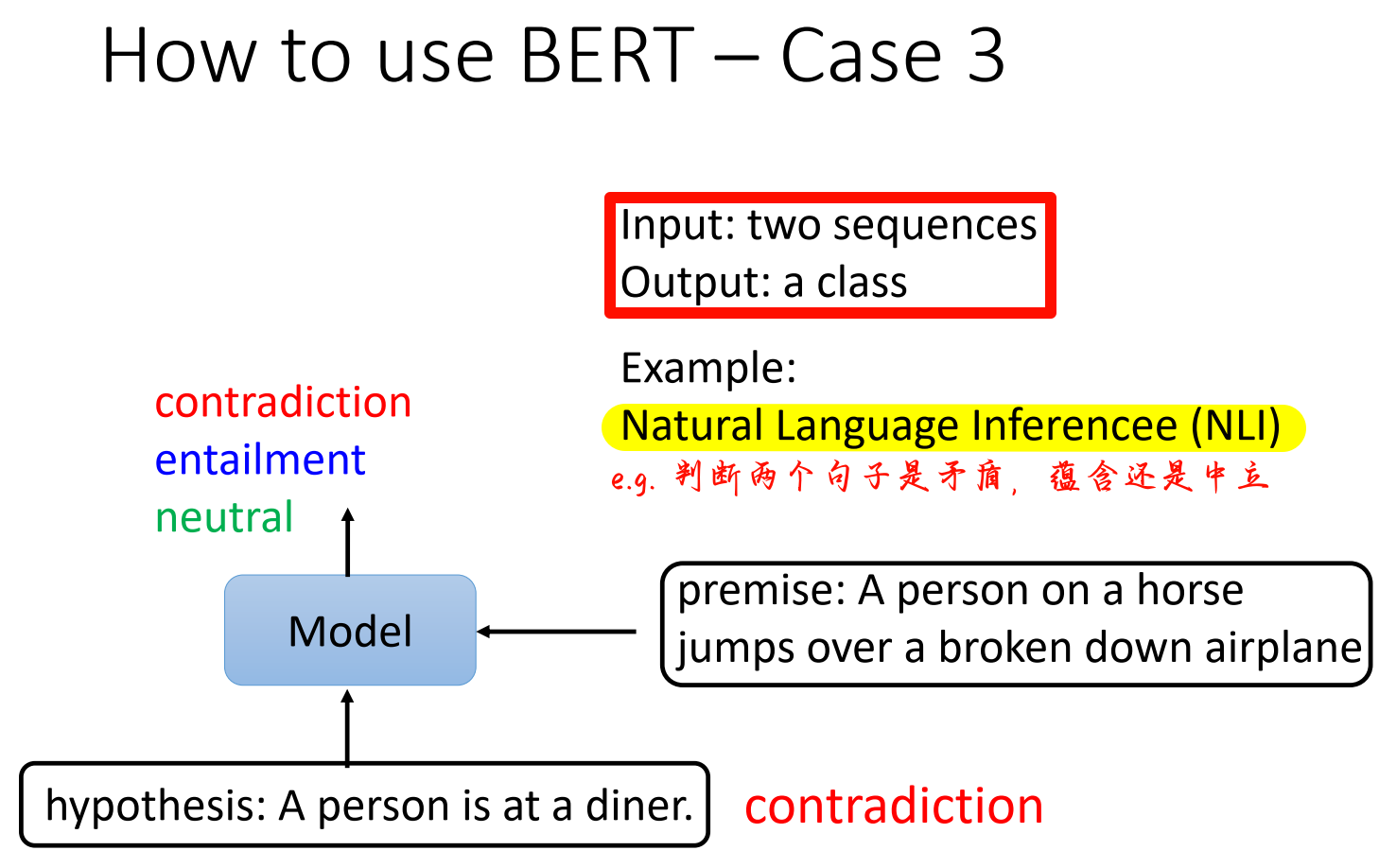

Case3

Case4

seq2seq model

前面都是训练 BERT 做填空题,但是它也可以训练做 seq2seq model

Why does BERT work

Explanation1

我们可以看见对于同一个”苹果“,苹果汁的”苹果“和苹果手机的”苹果“,BERT 的学习的 embedding 是不一样的的。看热力图可知,对于可以吃的”苹果“,BERT 算出的 embedding 都比较相似,而对于苹果公司的”苹果“,他们的 embedding 比较相似。所以我们可以说 BERT 好像能够理解词语的具体意思,知道”苹果“是可以吃的苹果还是苹果公司的苹果。

Explanation2

在 explanation1 中说到 BERT 似乎是靠理解词语的意思工作,但是经过实验发现,事实可能不是那么简单。

Multi-lingual BERT

GPT series